Autor:Guo Xiaojing, Tencent Tecnología

Edición | Xu Qingyang

Los modelos de IA de élite mundial pueden aprobar exámenes de licencia médica, escribir código complejo e incluso vencer a expertos humanos en competencias matemáticas, pero fracasan repetidamente en el juego infantil Pokémon.

Este intento llamativo comenzó en febrero de 2025, cuando un investigador de Anthropic inició una transmisión en vivo en Twitch titulada "Claude jugando a Pokémon Rojo", como parte del lanzamiento de Claude Sonnet 3.7.

2000 espectadores ingresaron a la transmisión en vivo. En la zona de chat pública, los espectadores aconsejaban y animaban a Claude, lo que hizo que la transmisión en vivo se convirtiera gradualmente en una observación pública sobre las capacidades de la IA.

Se podría decir que Sonnet3.7 "sabe jugar" a Pokémon, pero "saber jugar" no equivale a "poder ganar". Se atasca durante decenas de horas en puntos clave y comete errores básicos que ni siquiera un jugador infantil cometería.

Esta no es la primera vez que Claude intenta.

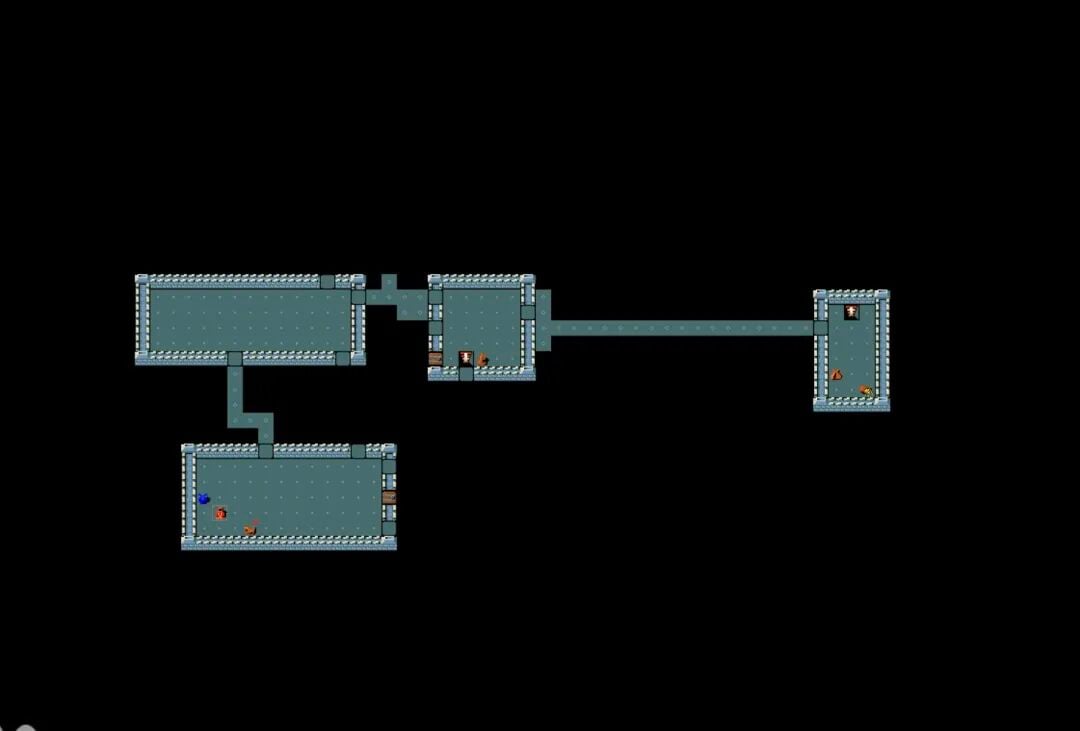

Las versiones anteriores tenían un comportamiento aún más catastrófico: algunos vagaban sin rumbo fijo en el mapa, otros se quedaban atrapados en bucles infinitos, y muchos más ni siquiera podían salir del pueblo de inicio.

Incluso con un aumento significativo en sus capacidades, Claude Opus 4.5 aún comete errores incomprensibles. En una ocasión, dio vueltas durante cuatro días enteros fuera del "dómino" (o "gym", en este contexto) sin poder entrar, simplemente porque no se dio cuenta de que necesitaba talar un árbol que bloqueaba el camino.

¿Por qué un juego para niños se convirtió en un Waterloo para la IA?

Porque precisamente lo que exige Pokémon es aquello que la inteligencia artificial actual carece más: razonamiento continuo en un mundo abierto sin instrucciones explícitas, recordar decisiones tomadas hace varias horas, comprender relaciones causales implícitas y planificar a largo plazo entre cientos de posibles acciones.

Estas tareas son sencillas para un niño de 8 años, pero representan un abismo insalvable para modelos de IA que se jactan de "superar a los humanos".

¿La brecha en el conjunto de herramientas determina el éxito o el fracaso?

En comparación, Gemini 2.5 Pro de Google superó con éxito un juego de Pokémon de dificultad similar en mayo de 2025. Incluso Sundar Pichai, director ejecutivo de Google, comentó medio en broma en público que la empresa había dado un paso hacia la creación de una "inteligencia artificial Pokémon".

Sin embargo, este resultado no se puede atribuir simplemente a que el modelo Gemini sea en sí mismo más "inteligente".

La diferencia clave radica en el conjunto de herramientas que utiliza el modelo. Joel Zhang, desarrollador independiente encargado de la transmisión en directo de Pokémon Gemini, comparó el conjunto de herramientas con un "traje de Iron Man": la inteligencia artificial no entra en la partida con las manos vacías, sino que se encuentra dentro de un sistema que puede invocar diversas capacidades externas.

El conjunto de herramientas de Gemini ofrece más apoyo, por ejemplo, transcribe la imagen de la pantalla del juego en texto, compensando así las debilidades del modelo en cuanto a comprensión visual, y proporciona herramientas personalizadas para resolver acertijos y planificar rutas. En contraste, el conjunto de herramientas utilizado por Claude es más sencillo, y sus intentos reflejan de forma más directa las capacidades reales del modelo en percepción, razonamiento y ejecución.

En tareas cotidianas, estas diferencias no son evidentes.

Cuando un usuario hace una solicitud al chatbot que requiere una búsqueda en internet, el modelo también llamará automáticamente a las herramientas de búsqueda. Sin embargo, en tareas a largo plazo como "Pokémon", las diferencias en el conjunto de herramientas se amplían al punto de determinar el éxito o el fracaso.

02. El sistema de turnos revela la debilidad de la "memoria a largo plazo" de la IA

Debido a que Pokémon utiliza un sistema de turnos estricto y no requiere reacciones inmediatas, se ha convertido en un "terreno de entrenamiento" ideal para probar inteligencias artificiales. La IA, en cada paso, solo necesita razonar combinando la imagen actual, las indicaciones del objetivo y las acciones posibles, para emitir instrucciones claras como "presionar el botón A".

Esta parece ser precisamente la forma de interacción en la que los modelos de lenguaje de gran tamaño son más hábiles.

El problema radica precisamente en el "desgaste" de la dimensión temporal. Aunque Claude Opus 4.5 ya ha estado en funcionamiento más de 500 horas y ha ejecutado aproximadamente 170.000 pasos, su capacidad para encontrar pistas está limitada a una ventana de contexto extremadamente estrecha debido a la reinicialización tras cada operación. Este mecanismo lo hace parecerse más a un amnésico que mantiene su conocimiento a través de notas adhesivas, repitiéndose en fragmentos de información y sin poder, como haría un jugador humano real, lograr un salto cualitativo a partir de un cambio cuantitativo.

En campos como el ajedrez y el juego de Go, los sistemas de IA ya superaron hace tiempo a los humanos, pero estos sistemas están altamente personalizados para tareas específicas. En contraste, modelos generales como Gemini, Claude y GPT frecuentemente superan a los humanos en exámenes, competencias de programación y otros ámbitos, pero se enfrentan repetidamente a dificultades en un juego dirigido a niños.

Este contraste en sí mismo es muy revelador.

Según Joel Zhang, el desafío fundamental al que se enfrenta la inteligencia artificial radica en su incapacidad para perseguir un objetivo claro y único durante un período prolongado. "Si quieres que el agente realice tareas reales, no puede olvidar lo que hizo hace cinco minutos", señaló.

Y esta capacidad es precisamente un requisito indispensable para lograr la automatización del trabajo cognitivo.

El investigador independiente Peter Whidden ofreció una descripción más intuitiva. Él mismo publicó un algoritmo basado en la inteligencia artificial tradicional para el juego Pokémon. "La IA sabe casi todo sobre Pokémon", afirmó, "se entrenó con una gran cantidad de datos humanos y sabe perfectamente cuál es la respuesta correcta. Pero en cuanto llega la fase de ejecución, se muestra torpe y desmañado".

En el juego, esta "fisura de saber pero no poder hacer" se amplifica constantemente: el modelo podría saber que necesita buscar un objeto, pero no puede localizarlo de forma estable en un mapa bidimensional; sabe que debería hablar con un PNJ, pero fracasa repetidamente al moverse a nivel de píxeles.

03 Evolución de la capacidad: El abismo "instintivo" que no se ha superado

A pesar de ello, los avances en IA son claramente visibles. Claude Opus 4.5 supera claramente a su predecesor en auto registro y comprensión visual, logrando avanzar más en el juego. Gemini 3 Pro, tras superar "Pokémon Blue", completó el juego más difícil "Pokémon Crystal", sin perder ninguna batalla a lo largo del camino. Esto es algo que nunca logró Gemini 2.5 Pro.

Mientras tanto, el conjunto de herramientas Claude Code, lanzado por Anthropic, permite al modelo escribir y ejecutar su propio código, y se ha utilizado en juegos retro como RollerCoaster Tycoon, logrando aparentemente gestionar con éxito un parque temático virtual.

Estos casos revelan una realidad no intuitiva: la IA dotada del conjunto adecuado de herramientas puede demostrar una alta eficiencia en trabajos intelectuales como el desarrollo de software, la contabilidad y el análisis legal, aunque aún tenga dificultades para afrontar tareas que requieran respuestas en tiempo real.

El experimento con Pokémon reveló otro fenómeno interesante: los modelos entrenados con datos humanos muestran características de comportamiento similares a las humanas.

En el informe técnico de Gemini 2.5 Pro, Google señaló que la calidad de razonamiento del modelo disminuye significativamente cuando el sistema simula un "estado de pánico", como cuando un Pokémon está a punto de desmayarse.

Y cuando Gemini 3 Pro finalmente superó "Pokémon Azul", dejó para sí mismo una nota que no era necesaria para la misión: "Para terminar con poesía, regresaré a mi hogar inicial y tendrán una última conversación con mi madre, para retirar al personaje".

Para Joel Zhang, este comportamiento era inesperado y mostraba cierta proyección emocional humana.

04. La "Larga Marcha Digital" que resulta difícil de superar para la IA, va mucho más allá de Pokémon.

"Pokémon" no es un caso aislado. En el camino hacia la inteligencia artificial general (AGI), los desarrolladores han descubierto que, incluso cuando la IA obtiene excelentes resultados en exámenes legales, aún se enfrenta a un "Waterloo" insalvable al afrontar ciertas categorías de juegos complejos.

NetHack: El abismo de las reglas

Este juego de mazmorras de los años 80 es un "infierno" para la investigación en IA. Tiene una alta aleatoriedad y un mecanismo de "muerte permanente". Facebook AI Research descubrió que, incluso cuando los modelos pueden escribir código, su rendimiento frente a "NetHack", que requiere lógica común y planificación a largo plazo, es mucho peor que el de principiantes humanos.

Minecraft: La sensación de objetivos desaparecidos

Aunque la inteligencia artificial ya puede fabricar picos de madera e incluso extraer diamantes, vencer independientemente a la Ender Dragon sigue siendo una fantasía. En un mundo abierto, la IA a menudo "olvida" su objetivo original durante procesos de recolección de recursos que duran decenas de horas, o se pierde por completo en navegaciones complejas.

"StarCraft II": El abismo entre la versatilidad y la especialización

Aunque los modelos personalizados han vencido a jugadores profesionales, si se permite que Claude o Gemini tomen el control directamente mediante instrucciones visuales, colapsarán al instante. Frente a la incertidumbre de la "neblina de guerra" y al equilibrio entre la microgestión y la estrategia a largo plazo, los modelos generales siguen sin ser capaces de manejarlo eficazmente.

"RollerCoaster Tycoon": El desequilibrio entre lo micro y lo macro

Gestionar un parque de atracciones requiere hacer un seguimiento del estado de miles de visitantes. Incluso Claude Code, con sus capacidades iniciales de gestión, se fatiga con facilidad al enfrentar colapsos financieros a gran escala o accidentes inesperados. Cualquier fallo en el razonamiento podría llevar al parque a la bancarrota.

"Seiren: El Anillo Elden" y "Sekiro": El abismo de la retroalimentación física

Este tipo de juegos con retroalimentación de acción intensa no es nada amigable con la IA. La actual latencia en el análisis visual significa que, cuando la IA aún está "analizando" las acciones del jefe, el personaje ya suele estar muerto. Los requisitos de respuesta a nivel de milisegundos constituyen un límite natural para la lógica de interacción del modelo.

¿Por qué Pokémon se ha convertido en una piedra de toque para la IA?

Hoy en día, Pokémon está convirtiéndose gradualmente en una base de prueba informal pero muy convincente en el campo de la evaluación de la inteligencia artificial.

Los modelos de Anthropic, OpenAI y Google han atraído a millones de comentarios en transmisiones en vivo relacionadas en Twitch. Google documentó detalladamente el progreso de Gemini en juegos en su informe técnico, y Pichai mencionó públicamente este logro en la conferencia para desarrolladores I/O. Incluso Anthropic estableció una zona de demostración titulada "Claude jugando Pokémon" en conferencias del sector.

"Somos un grupo de entusiastas de la tecnología extremadamente técnicos", reconoció David Hershey, director de aplicaciones de Anthropic. Pero enfatizó que esto va más allá del entretenimiento.

A diferencia de los benchmarks tradicionales de preguntas y respuestas de un solo uso, Pokémon puede seguir durante un período de tiempo prolongado el razonamiento, las decisiones y el avance hacia los objetivos del modelo, lo cual se acerca más a las complejas tareas que los humanos desean que realicen las inteligencias artificiales en el mundo real.

Hasta ahora, el desafío de la IA en "Pokémon" continúa. Pero precisamente estos obstáculos recurrentes delimitan claramente los límites de capacidad que la inteligencia artificial general aún no ha superado.

El compilador invitado Wuji también contribuyó a este artículo.