Autor:Guo Xiaojing, Tencent Technology

Edição | Xu Qingyang

Os modelos de IA de ponta do mundo podem passar nos exames de licença médica, escrever código complexo e até superar especialistas humanos em competições matemáticas, mas têm falhado repetidamente num jogo infantil, Pokémon.

Esta notável tentativa começou em fevereiro de 2025, quando um investigador da Anthropic iniciou uma transmissão em direto no Twitch intitulada "Claude a jogar Pokémon Vermelho", coincidindo com o lançamento do Claude Sonnet 3.7.

2000 espectadores entraram no transmissão em direto. Na zona de bate-papo pública, os espectadores aconselhavam e apoiavam o Claude, transformando gradualmente esta transmissão em direto numa observação pública sobre as capacidades da IA.

O Sonnet3.7 apenas pode ser descrito como "saber brincar" com Pokémon, mas "saber brincar" não é equivalente a "ganhar". Ele pode ficar bloqueado durante dezenas de horas em pontos-chave e cometer erros básicos que até mesmo jogadores infantis não cometeriam.

Esta não é a primeira tentativa do Claude.

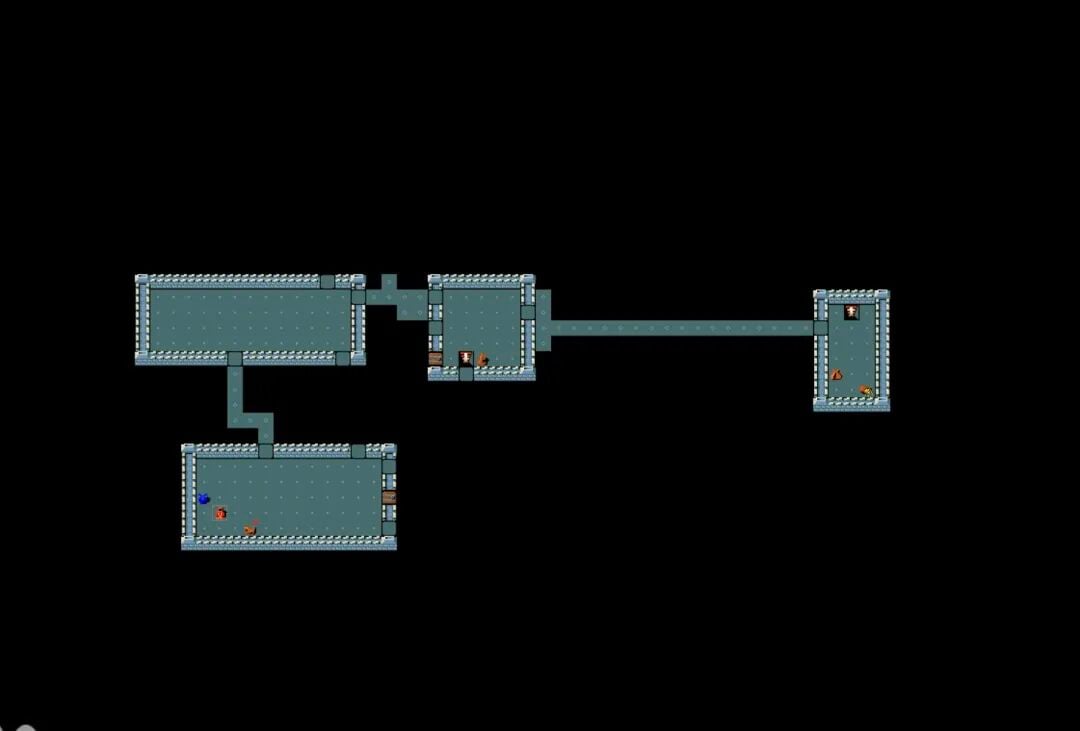

As versões iniciais tinham um desempenho ainda mais desastroso: algumas vagavam sem objectivo no mapa, outras ficavam presas em ciclos infinitos, e muitas mais nem sequer conseguiam sair do vilarejo inicial.

Mesmo o Claude Opus 4.5, com uma melhoria significativa nas capacidades, ainda comete erros inesperados. Uma vez, ele deambulou durante quatro dias fora do "douguan" (centro Pokémon) sem conseguir entrar, simplesmente porque não percebeu que precisava cortar uma árvore que bloqueava o caminho.

Por que um jogo infantil se tornou um desafio para a IA?

Porque o que Pokémon exige é exatamente a capacidade mais escassa nos AIs atuais: raciocínio contínuo num mundo aberto sem instruções explícitas, memória de decisões tomadas há horas, compreensão de relações causais implícitas e planeamento a longo prazo entre centenas de ações possíveis.

Essas tarefas são fáceis para uma criança de 8 anos, mas constituem um abismo intransponível para modelos de IA que se gabam de "superar os humanos".

01 A lacuna entre os conjuntos de ferramentas determina o sucesso ou o fracasso?

Por comparação, o Gemini 2.5 Pro da Google conseguiu completar com sucesso um jogo de Pokémon de dificuldade semelhante em maio de 2025. O próprio CEO da Google, Sundar Pichai, chegou até a brincar meio em tom de brincadeira, em público, dizendo que a empresa deu um passo em direção à criação de uma "inteligência artificial Pokémon".

No entanto, este resultado não pode ser simplesmente atribuído ao facto de o modelo Gemini ser, por si só, "mais inteligente".

A principal diferença reside no conjunto de ferramentas utilizado pelo modelo. Joel Zhang, desenvolvedor independente responsável pela transmissão em direto do Pokémon Gemini, compara o conjunto de ferramentas a um "traje de Homem de Ferro": a inteligência artificial não entra no jogo com as mãos vazias, mas sim num sistema que pode aceder a múltiplas capacidades externas.

O conjunto de ferramentas do Gemini oferece mais suporte, como a transcrição da imagem do jogo para texto, compensando assim as fraquezas do modelo em termos de compreensão visual, e fornecendo ferramentas personalizadas para resolver enigmas e planejar percursos. Por contraste, o conjunto de ferramentas utilizado pelo Claude é mais simples, e as suas tentativas refletem de forma mais direta as capacidades reais do modelo em termos de percepção, raciocínio e execução.

Estas diferenças não são evidentes nas tarefas do dia a dia.

Quando os utilizadores fazem perguntas ao chatbot que requerem uma pesquisa na Internet, o modelo também chama automaticamente as ferramentas de pesquisa. No entanto, em tarefas de longo prazo como o jogo Pokémon, as diferenças entre os conjuntos de ferramentas são ampliadas ao ponto de determinar o sucesso ou o fracasso.

02 Sistema de turnos expõe a fraqueza de memória de longo prazo da IA

Devido ao facto de Pokémon utilizar um sistema estrito de turnos e não exigir respostas instantâneas, tornou-se um "campo de treino" ideal para testar a inteligência artificial. A IA, em cada passo, apenas precisa de raciocinar com base na imagem actual, nas indicações do objectivo e nas acções disponíveis, podendo assim emitir instruções claras, como "pressionar o botão A".

Parece que esta é exatamente a forma de interação em que os modelos de linguagem de grande escala são mais especializados.

O problema está precisamente no "descontinuidade" da dimensão temporal. Apesar de o Claude Opus 4.5 já ter executado mais de 500 horas e cerca de 170 mil passos, a reinitialização após cada operação limita o modelo a procurar pistas apenas num pequeno espaço de contexto. Este mecanismo faz com que ele se pareça mais com um esquecido que depende de notas adesivas para manter a cognição, repetindo-se em fragmentos de informação e nunca conseguindo, como um verdadeiro jogador humano, atingir uma transformação qualitativa a partir de uma acumulação quantitativa de experiência.

Nos campos do xadrez e do Go, os sistemas de IA já ultrapassaram há muito tempo os humanos, mas estes sistemas são altamente personalizados para tarefas específicas. Por contraste, modelos gerais como Gemini, Claude e GPT frequentemente vencem humanos em exames e competições de programação, mas encontram repetidas dificuldades num jogo direcionado a crianças.

Essa contraposição em si mesma é altamente reveladora.

Para Joel Zhang, o desafio central enfrentado pela IA reside na incapacidade de perseguir objectivos claros e únicos ao longo de longos períodos de tempo. "Se quiseres que os agentes inteligentes realizem tarefas reais, eles não podem esquecer o que fizeram há cinco minutos", apontou ele.

E esta capacidade é exatamente o pressuposto indispensável para a automação do trabalho cognitivo.

Peter Whidden, um investigador independente, forneceu uma descrição mais intuitiva. Ele open-sourceou um algoritmo baseado em IA tradicional para "Pokémon". "A IA sabe praticamente tudo sobre 'Pokémon'", afirmou ele, "foi treinada com uma quantidade imensa de dados humanos e sabe claramente qual é a resposta correta. Mas, assim que chega à fase de execução, torna-se extremamente desajeitada."

Dentro do jogo, essa "fissura de saber mas não conseguir" é constantemente ampliada: o modelo pode saber que precisa procurar um item, mas não consegue localizá-lo de forma estável num mapa bidimensional; sabe que deveria falar com um PNJ, mas falha repetidamente nos movimentos a nível de píxeis.

03 A evolução das capacidades: A lacuna "instintiva" que ainda não foi ultrapassada

Apesar disso, o progresso da IA é claramente visível. O Claude Opus 4.5 supera claramente a geração anterior em auto-registo e compreensão visual, permitindo avançar mais longe no jogo. O Gemini 3 Pro, depois de completar "Pokémon Blue", terminou o jogo mais difícil "Pokémon Crystal", sem perder uma única batalha ao longo de todo o processo. Isto é algo que o Gemini 2.5 Pro nunca conseguiu alcançar.

Ao mesmo tempo, o conjunto de ferramentas Claude Code, lançado pela Anthropic, permite que os modelos escrevam e executem código próprio, tendo sido usado em jogos retro como RollerCoaster Tycoon, e supostamente consegue gerir com sucesso um parque temático virtual.

Estes casos revelam uma realidade contra-intuitiva: A I dotada de um conjunto adequado de ferramentas pode demonstrar uma eficiência extremamente elevada em trabalhos intelectuais, como desenvolvimento de software, contabilidade e análise jurídica, mesmo que ainda tenha dificuldade em lidar com tarefas que exijam reações em tempo real.

O experimento com Pokémon revelou ainda outro fenómeno intrigante: modelos treinados com dados humanos exibem características comportamentais semelhantes às humanas.

No relatório técnico do Gemini 2.5 Pro, a Google afirma que a qualidade de raciocínio do modelo diminui significativamente quando o sistema simula um "estado de pânico", como quando um Pokémon está prestes a desmaiar.

E quando o Gemini 3 Pro finalmente completou Pokémon Blue, deixou uma nota pessoal, que não fazia parte da missão: "Para terminar poeticamente, vou voltar para casa pela primeira vez e ter uma última conversa com a minha mãe, aposentando o personagem."

Para Joel Zhang, este comportamento foi inesperado e continha uma projeção emocional de alguma espécie, quase humana.

04. A "longa marcha digital" que a IA tem dificuldade em superar vai muito além de "Pokémon"

Pokémon não é um caso isolado. Ao longo do caminho em direção à inteligência artificial geral (AGI), os desenvolvedores descobriram que, mesmo que a IA obtenha resultados excelentes em exames jurídicos, ainda encontra um "Waterloo" difícil de ultrapassar quando se depara com alguns tipos de jogos complexos.

NetHack: A Profundeza das Regras

Este jogo de dungeon dos anos 80 é um "pesadelo" para a investigação em IA. É extremamente aleatório e tem o mecanismo de "morte permanente". A Facebook AI Research descobriu que, mesmo sendo capazes de escrever código, os modelos desempenham-se muito pior do que principiantes humanos no jogo NetHack, que exige lógica comum e planeamento a longo prazo.

Minecraft: O Sentimento de Objetivo Desaparecido

Embora a inteligência artificial já consiga fabricar picaretas de madeira e até minerar diamantes, vencer independentemente o Ender Dragon ainda é um mito. Num mundo aberto, a IA frequentemente "esquece" o seu objetivo original durante processos de recolha de recursos que duram dezenas de horas, ou perde-se completamente em navegações complexas.

StarCraft II: A Fractura Entre Generalidade e Especialização

Apesar de modelos personalizados terem vencido jogadores profissionais, se deixarmos que Claude ou Gemini assumam diretamente através de instruções visuais, eles desmoronarão imediatamente. Ao lidar com a incerteza da "neblina de guerra" e ao equilibrar microgestão com desenvolvimento estratégico, modelos gerais ainda são insuficientemente capazes.

RollerCoaster Tycoon: O Desequilíbrio entre Micro e Macro

Gerir um parque temático requer acompanhar o estado de milhares de visitantes. Mesmo o Claude Code, com capacidades iniciais de gestão, pode facilmente demonstrar sinais de fadiga ao lidar com colapsos financeiros em grande escala ou acidentes súbitos. Qualquer falha na capacidade de raciocínio pode levar ao colapso do parque.

"Rings of Elden" e "Sekiro": A Lacuna da Física

Este tipo de jogos com forte realimentação de ação é extremamente desfavorável para a IA. O atraso atual na análise visual significa que, quando a IA ainda está "a pensar" sobre as ações do chefe, o personagem já frequentemente está caído. Os requisitos de resposta a nível de milissegundos constituem um limite natural para a lógica de interação do modelo.

Por que Pokémon tornou-se um teste para a IA?

Atualmente, "Pokémon" está gradualmente a tornar-se um padrão de teste informal, mas muito persuasivo, no campo da avaliação de IA.

Os modelos da Anthropic, OpenAI e Google atraíram milhões de comentários em transmissões relacionadas no Twitch. A Google documentou em detalhe o progresso do Gemini em jogos num relatório técnico, e Pichai mencionou publicamente este feito na conferência para desenvolvedores I/O. A Anthropic até criou uma área de demonstração chamada "Claude jogando Pokémon" em conferências do setor.

"Somos um grupo de entusiastas super técnicos", admitiu David Hershey, diretor de Aplicações de IA da Anthropic. Mas ele enfatiza que isso não é apenas entretenimento.

Ao contrário dos benchmarks tradicionais baseados em perguntas e respostas únicas, o Pokémon consegue acompanhar continuamente o raciocínio, as decisões e o progresso em direção aos objetivos do modelo ao longo de um período muito prolongado, sendo mais próximo das tarefas complexas que os humanos desejam que os sistemas de IA realizem no mundo real.

Até à data, os desafios enfrentados pela IA em "Pokémon" continuam. Mas são precisamente estas dificuldades recorrentes que delineiam claramente os limites de capacidade que a inteligência artificial geral ainda não ultrapassou.

O compilador convidado Wuji também contribuiu para este artigo.